Fornir – tańsza alternatywa dla litego drewna.

Co to jest fornir i jak powstaje?

Fornir to cienki płat drewna, zazwyczaj o grubości od 0,1 do 3 mm, uzyskany w procesie łuszczenia, strugania...

Jak dobrać biżuterię do dekoltu? Przewodnik po stylowych połączeniach

Dobór odpowiedniej biżuterii do dekoltu to klucz do stworzenia spójnej i efektownej stylizacji. Biżuteria, choć często traktowana jako dodatek, ma moc podkreślenia atutów i...

BYD: Chiński Gigant, który Zrewolucjonizował Motoryzację

BYD, czyli Build Your Dreams, to nazwa, która w ostatnich latach stała się synonimem szybkiego rozwoju i innowacji w branży motoryzacyjnej. Ten chiński koncern,...

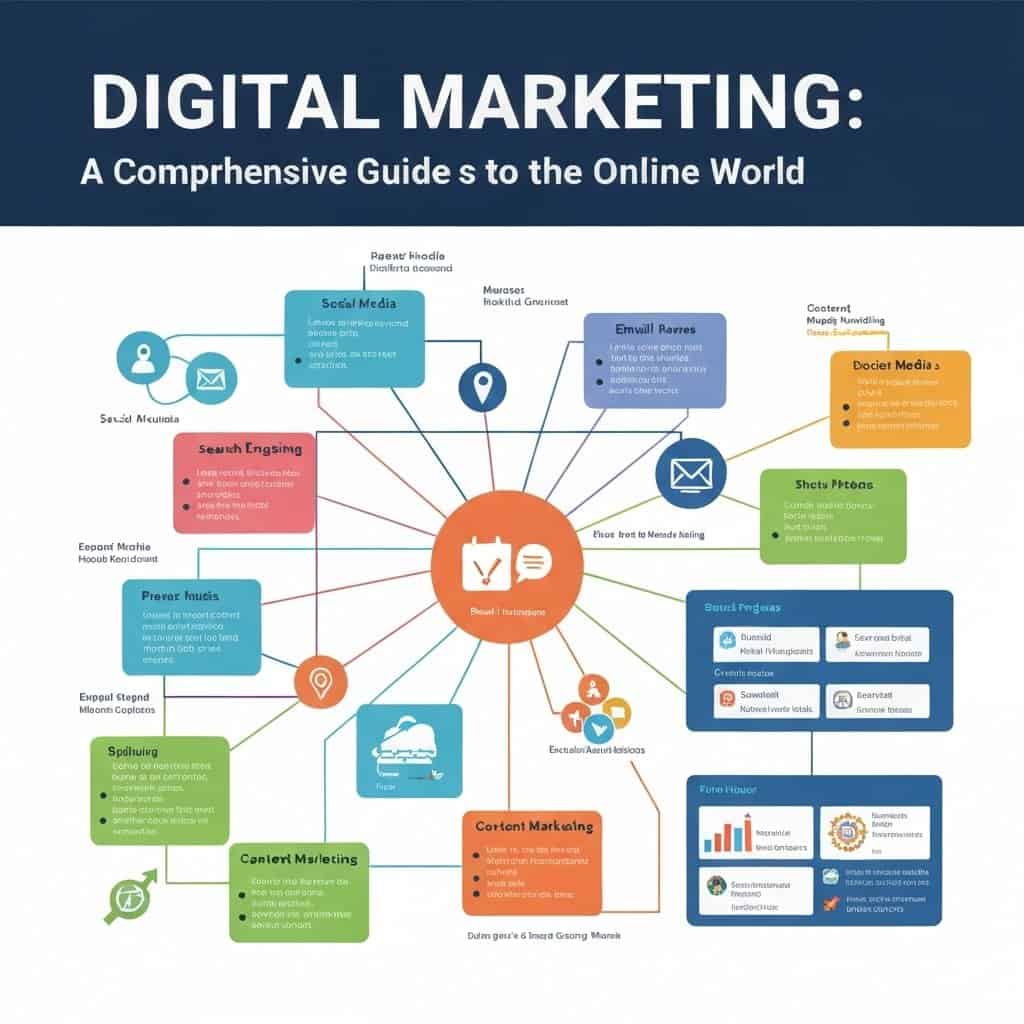

Marketing cyfrowy: Kompletny przewodnik po świecie online

Marketing cyfrowy, znany również jako digital marketing, to dynamicznie rozwijająca się dziedzina, która obejmuje wszystkie działania promocyjne prowadzone w przestrzeni internetowej. Jego celem jest...

Kwasy tłuszczowe wielonienasycone: Klucz do zdrowia i witalności

Kwasy tłuszczowe wielonienasycone, często określane skrótem wntk, stanowią niezwykle ważny element naszej diety. Są to tłuszcze, których cząsteczki zawierają więcej niż jedną podwójną wiązkę...

Problem wypalenia zawodowego i jak mu zapobiegać

Czym jest wypalenie zawodowe?

Wypalenie zawodowe to stan fizycznego, emocjonalnego i psychicznego wyczerpania spowodowany długotrwałym stresem związanym z pracą. Nie jest to chwilowe zmęczenie, lecz...

Ewolucja algorytmów handlowych: Od prostych reguł do sztucznej inteligencji

Początki algorytmów handlowych: Era prostych strategii

Początki algorytmów handlowych sięgają czasów, gdy inwestorzy zaczęli poszukiwać sposobów na systematyzację swoich decyzji i wyeliminowanie wpływu emocji na...

Funkcjonalizm w architekturze i designie: „Forma podąża za funkcją”

Funkcjonalizm, jako kluczowa zasada w architekturze i projektowaniu wnętrz, opiera się na fundamentalnym założeniu, że forma obiektu lub przestrzeni powinna być bezpośrednio podyktowana jego...

Jak przygotować się do sesji zdjęciowej: Kompleksowy przewodnik

Zrozumienie celu sesji: Klucz do sukcesu

Zanim rozpoczniesz jakiekolwiek przygotowania, kluczowe jest zrozumienie celu Twojej sesji zdjęciowej. Czy jest to sesja portretowa, biznesowa, modowa, rodzinna,...

Citroën Dyane: Ikona Francuskiej Motoryzacji

Citroën Dyane, choć często pozostaje w cieniu swojego słynnego poprzednika, modelu 2CV, jest pojazdem zasługującym na szczególną uwagę. Zaprojektowany jako bardziej praktyczna i komfortowa...