BERT, czyli Bidirectional Encoder Representations from Transformers, to przełomowy model językowy opracowany przez Google, który znacząco zmienił sposób, w jaki komputery rozumieją i przetwarzają ludzki język. Jego innowacyjna architektura i sposób treningu pozwoliły na osiągnięcie bezprecedensowych wyników w szerokim spektrum zadań związanych z przetwarzaniem języka naturalnego (NLP), od tłumaczenia maszynowego po analizę sentymentu.

Geneza i kluczowe innowacje BERTa

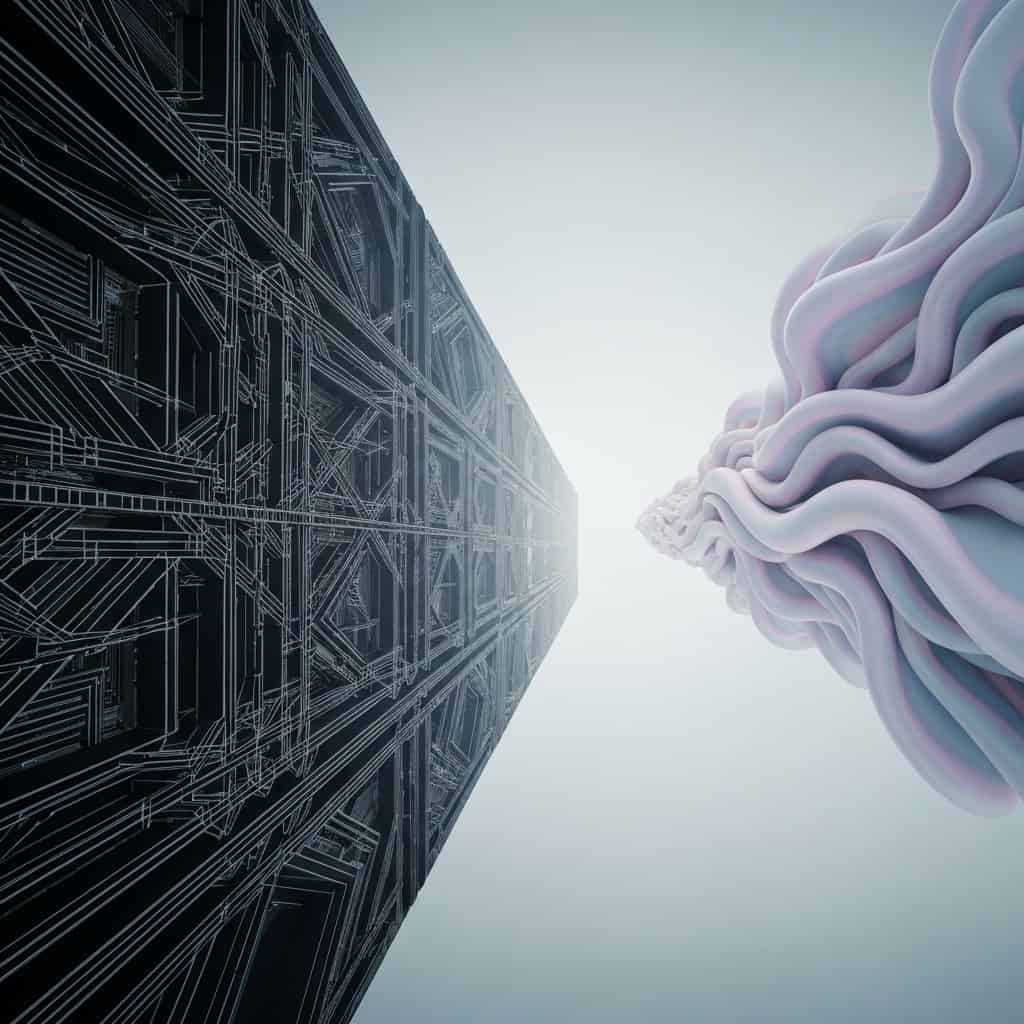

Tradycyjne modele NLP często przetwarzały tekst w sposób sekwencyjny, analizując słowa jedno po drugim. BERT, oparty na architekturze Transformer, wprowadził dwukierunkową analizę kontekstu. Oznacza to, że model jest w stanie jednocześnie uwzględnić zarówno słowa poprzedzające, jak i następujące po danym słowie w zdaniu. Ta kontekstualizacja na poziomie słowa jest kluczowa dla głębszego zrozumienia niuansów językowych, takich jak homonimia czy wieloznaczność.

Inną istotną innowacją było zastosowanie pre-treningu na ogromnych zbiorach danych tekstowych. BERT był wstępnie trenowany na miliardach słów z książek i artykułów z Wikipedii, co pozwoliło mu nauczyć się ogólnych zależności gramatycznych, semantycznych i faktograficznych języka. Dopiero po tym etapie model był dostrajany (fine-tuned) do konkretnych zadań NLP, co wymagało znacznie mniejszej ilości danych specyficznych dla danej aplikacji.

Mechanizm uwagi (Attention Mechanism)

Sercem architektury Transformer, a tym samym BERTa, jest mechanizm uwagi. Pozwala on modelowi dynamicznie oceniać ważność poszczególnych słów w kontekście całego zdania lub nawet większego fragmentu tekstu. Dzięki temu BERT może skupić się na najważniejszych informacjach podczas przetwarzania i generowania odpowiedzi, co przekłada się na jego wysoką skuteczność.

Jak działa BERT? Podstawy techniczne

BERT wykorzystuje architekturę enkodera Transformer, która składa się z wielu warstw analizujących dane wejściowe. Każda warstwa przetwarza reprezentacje słów, wzbogacając je o informacje kontekstowe. Kluczowe techniki używane podczas treningu BERT to:

- Masked Language Model (MLM): W tej technice około 15% słów w zdaniu jest losowo maskowanych, a zadaniem modelu jest odgadnięcie tych zamaskowanych słów na podstawie pozostałego kontekstu. To zmusza BERT do nauki głębokiego zrozumienia relacji między słowami.

- Next Sentence Prediction (NSP): W tym zadaniu model otrzymuje dwie sekwencje tekstu i musi przewidzieć, czy druga sekwencja jest logicznym następstwem pierwszej. Pomaga to BERTowi w rozumieniu relacji między zdaniami i poprawia jego zdolność do analizy dłuższych fragmentów tekstu.

Po zakończeniu pre-treningu, model BERT można specjalizować dla różnych zadań NLP, takich jak:

- Klasyfikacja tekstu: Określanie kategorii, do której należy dany tekst (np. spam, pozytywna opinia).

- Odpowiadanie na pytania: Znajdowanie odpowiedzi na pytania w podanym tekście.

- Rozpoznawanie nazwanych jednostek (NER): Identyfikowanie i kategoryzowanie nazw własnych, takich jak osoby, miejsca czy organizacje.

- Tłumaczenie maszynowe: Automatyczne tłumaczenie tekstu z jednego języka na inny.

Zastosowania BERT w praktyce

Wpływ BERT na branżę technologiczną jest ogromny. Jego zdolność do precyzyjnego rozumienia języka sprawia, że jest on wykorzystywany w wielu aplikacjach, które ułatwiają nam codzienne życie i pracę.

Wyszukiwarki internetowe

Google, twórca BERTa, wykorzystuje ten model do lepszego rozumienia zapytań użytkowników w swojej wyszukiwarce. Dzięki temu wyniki wyszukiwania są bardziej trafne, nawet gdy zapytania są złożone lub sformułowane w sposób potoczny. BERT pomaga zrozumieć intencję użytkownika, co prowadzi do lepszych rezultatów.

Asystenci głosowi i chatboty

Modele oparte na BERT znacząco poprawiają interakcje z asystentami głosowymi i chatbotami. Pozwalają im na bardziej naturalną i płynną rozmowę, lepsze rozumienie poleceń i udzielanie trafniejszych odpowiedzi.

Analiza sentymentu i monitorowanie mediów społecznościowych

BERT jest wykorzystywany do analizy nastrojów w opiniach klientów, recenzjach produktów czy wpisach w mediach społecznościowych. Umożliwia to firmom szybsze reagowanie na potrzeby klientów i lepsze zrozumienie ich percepcji marki.

Tworzenie treści i podsumowań

Zaawansowane wersje modeli opartych na BERT mogą być wykorzystywane do generowania podsumowań długich tekstów lub nawet do tworzenia prostych treści informacyjnych, co stanowi cenne narzędzie dla dziennikarzy i analityków.

Przyszłość BERT i jego następcy

BERT zapoczątkował nową erę w NLP, inspirując rozwój wielu kolejnych, jeszcze bardziej zaawansowanych modeli, takich jak RoBERTa, XLNet czy GPT-3. Choć te nowe modele często przewyższają BERT pod względem wydajności, to właśnie fundamentalne innowacje wprowadzone przez BERT stanowią podstawę ich rozwoju.

Badania nad modelami językowymi nadal ewoluują, skupiając się na zwiększeniu ich efektywności, zmniejszeniu zapotrzebowania na moc obliczeniową oraz na lepszym rozumieniu i generowaniu języka w sposób kreatywny i logiczny. BERT pozostaje kamieniem milowym w tej dziedzinie, a jego dziedzictwo będzie nadal kształtować przyszłość sztucznej inteligencji.